英语中有个词叫做keep someone at arm's length(保持一臂之距,意为“敬而远之”),形容英特尔和AMD多年以来的关系最确切不过。不过,正如大家所看到的,这两家芯片巨头近期正在缩短彼此间的距离,促成此的正是——Arm的力量。

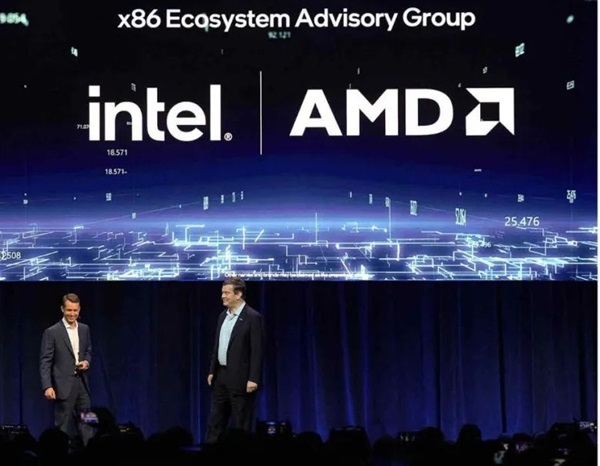

10月15日,在于美国西雅图举行的联想创新科技大会上, 英特尔CEO 帕特·基辛格宣布,与AMD成立x86生态系统顾问小组。这也是长期互为竞争对手的两家公司的罕见合作。不顾一臂之距彼此 “抱团”的背后,是x86对Arm一再提升的生态影响力的反击。

Arm做了什么?

以芯片架构IP授权为主营业务的Arm,生态组建几乎是其生命线和盈利来源之所在。Arm的盈利来源,一方面是向芯片设计企业授权其架构IP,采用其芯片内核架构的企业,可以选择付单次流片费用,可以买三年内无限次流片,还可以永久买断;另一方面来自于收取芯片设计企业的版税,即其客户芯片量产后,Arm会根据产量按百分比收取版税。

在这样的商业模式下,Arm建立自身竞争力的途径有两条。一是发展更多的客户,二是为客户打通上下游。二者相辅相成,为Arm建造起规模相当庞大的“朋友圈”。

在拓展芯片设计客户这条路上,Arm走得很成功。凭借在低功耗方面的独特优势,在消费电子和AIoT应用场景中,Arm几乎成为芯片架构IP授权“断层领先”的存在。近几年增长势头很猛的RISC-V生态中,基本上每一款新产品的推出都以Arm某系列产品为标的。

在手机芯片市场,Arm斩获了一众头部企业客户:高通、苹果、三星、联发科……ARM架构成为上述客户每年更新的旗舰芯片的首选架构。

为了增强客户粘性、提升客户体验,Arm花了大量的工作“为客户扫清障碍”。在软件生态层面,担心软件在客户的芯片上跑得不够顺畅,事先与软件企业乃至APP开发者建立联系,以保证架构设计与软件应用的适配度。在硬件生态层面,担心客户芯片设计完成后在后期流片过程与代工厂交涉不顺利,事先与台积电等代工企业跑通路径,降低客户流片难度。

在产品交付方面,Arm提供的服务也越来越“保姆级”。为了方便此前选择多款IP组合成“多核芯片”的客户,Arm开始提供“打包”服务——事先对内核进行排列组合,形成一套“开机即用”的解决方案,客户可以根据性能表现、功耗表现等选择不同类型的组合方案,也就能在芯片内核选用与组合过程中节省一部分时间。今年5月,Arm的“保姆式”服务再升级,甚至连IP在EDA工具中的工具流都能打包交付。

原本ARM和x86可以各自在移动端和PC与数据中心端分庭而治。但近几年,Arm在PC端乃至数据中心的动作越来越多。在PC方面, 2023年10月骁龙峰会期间,高通推出面向PC打造的基于Arm架构的骁龙X Elite 芯片;今年5月,高通与微软公司宣布合作,推出面向Windows的骁龙开发套件,微软宣布其首批推出的Copilot+PC将搭载基于Arm架构的高通骁龙X Elite处理器, “Windows on Arm”更进一步。

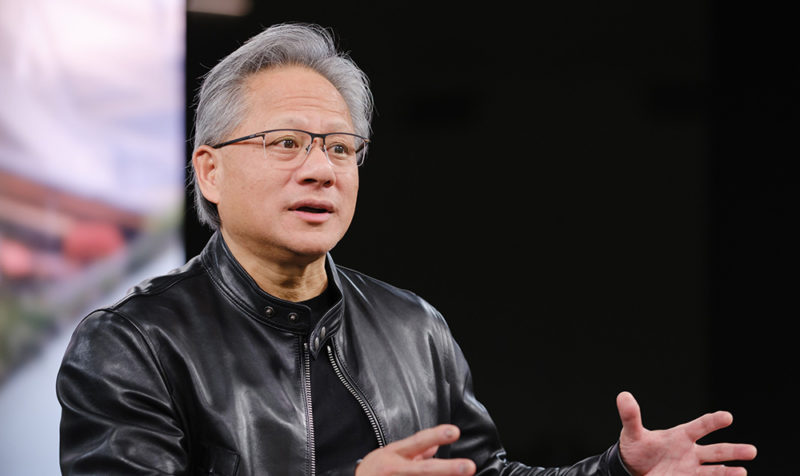

自2019年开始,亚马逊、Ampere等企业纷纷开始尝试采用ARM架构设计服务器CPU,并相较于英特尔、AMD的拳头产品实现了能耗、成本双降低。尤其是英伟达推出的144核超级CPU采用ARM架构,更是帮Arm扩大了在高性能数据中心场景中的影响力。在PC和数据中心生态大力拓展的Arm,彻底触碰了x86厂商的“蛋糕”。

x86的反击

面对Arm咄咄逼人的生态攻势,以英特尔、AMD等为核心的x86阵营坐不住了。尽管英特尔、AMD在长达几十年的时间里互为竞争对手,明里暗里争斗不断。但在对抗共同的竞争对手Arm的事情上,二者还是站到了一起。

过去几十年,英特尔和AMD在指令集架构设计上走的是独立的设计路线。生态伙伴选择英特尔或者AMD,都需要将技术路线重新验证一遍。

“不同x86供应商之间的接口不一致,会导致重复的软件开发、测试、部署、维护等问题。这会降低我们生态系统的价值。” 英特尔数据中心与AI执行副总裁Justin Hotard说。

当前,摩尔定律正面临失效可能,芯片设计周期大大缩短,迭代速度大大加快。从芯片设计企业的旗舰芯片发布会从一年一发渐渐转变为一年多发就可见端倪。尤其是在“卷王”Arm,不断强调帮助客户缩短设计周期的能力,不断降低芯片设计企业自研高性能芯片门槛的情况下,如果不能帮助客户降低应用难度,将会有更多客户“跑单”。

由此,在10月15日于美国西雅图举行的联想创新科技大会上,英特尔CEO 帕特·基辛格宣布,与AMD成立x86生态系统顾问小组。

10月16日,在美国举行的2024开放计算项目全球峰会(2024 OCP Global Summit,以下简称“2024 OCP”)上,Justin Hotard再次强调这一举措的目标:“我们希望让AI时代的整个生态系统更容易和更简单地继续使用x86并从中受益。”

在2024 OCP活动上,AMD数据中心解决方案执行副总裁Forrest Norrod也强调了合作的重要性:有的公司会说,要由一家公司来完成设计、硬件和软件的基本架构,这是计算机行业早期的处事方式。“在AMD,我们坚信,真正的开放才是正确的前进方式。为了在开放的水平上共同优化和协作共同设计,必须将所有生态系统整合在一起。”Forrest Norrod说。

在10月16日,2024OCP活动上,AMD数据中心解决方案执行副总裁Forrest Norrod和英特尔数据中心与AI执行副总裁Justin Hotard介绍x86生态顾问小组未来前景

x86生态顾问小组有三大预期目标:为客户在硬件和软件方面提供更多选择和更强的兼容性,使其更快地受益于全新的尖端功能;简化架构指南,以提升英特尔和AMD的x86产品系列在软件一致性和接口方面的表现;使新功能更广泛、更高效地集成到操作系统、框架和应用程序中将简化生态系统软件开发和维护,为开发人员减少摩擦,以最大限度地提升效率并加速创新。

x86生态系统顾问小组以云计算场景为核心,创始成员业务涵盖云计算、云原生应用开发、服务器等环节,这也显示出x86“抱团”的决心。

争夺AI制高点

在数据中心场景中,谁能把AI带来的高能耗打下来,成为生态争夺的关键。

训练大模型所需的功耗正在增加。在满足训练大模型过程中,芯片性能的提升也伴随着惊人的功耗。AI服务器每个机架的功率提高了20倍。研究表明,数据中心能耗至少在未来四年内将翻一番。

10月15日,Meta宣布将发布专为AI工作负载设计的高性能机架Catalina,基于NVIDIA Blackwell设计,旨在支持NVIDIA GB200 Grace Blakwell超级芯片,其功率高达140kW。

近日,AMD展示了一组数据,由于不断增加的计算需求,在数据中心场景,从芯片到服务器、机架、数据中心的链条上,每个环节的能耗密度都在增加。

“一个小芯片内部署了数千万平方毫米的硅,过去500W左右的功耗,现在提高到千瓦以上,而在非常近的未来,这一数字将提高到2kW以上。”Forrest Norrod说。当前,单机架功耗已经提高到250kW,一个大规模计算集群的计算节点已经达到10万个。

高功耗带来的是不可持续。

Arm 基础设施市场推广副总裁Eddie Ramirez近日公开表示:“一个250kW的机架所需的电量大致相当于一个社区。而当前世界上没有多少地方能够应对这种巨量的耗电需求。虽然当前的技术可以实现对设备进行冷却,但难以支持大规模部署。”

为此,芯片供应商正越来越重视功耗指标。

Justin Hotard介绍了英特尔在帮助客户降低大规模计算能耗的最新成效。NAVER Cloud是一家专注于提供超大规模AI云平台的韩国企业,该企业使用英特尔最新一代计算平台Gaudi 2进行优化后,功耗效率已经和英伟达H100的推理平台不相上下。

Arm公司首席执行官Rene Haas表示,与大型语言模型中的H100 GPU相比,Arm架构实现的系统级设计优化将把功耗降低至1/25,并将每个GPU的性能提高30倍。

当前,芯片巨头竞争的关键,正在逐渐从性能焦点扩散开,单芯片性能、与系统的适配性、功耗,成为下游客户衡量产品优劣的新标准。尤其是在数据中心场景,能耗表现成为大客户考察的重点。而系统能耗表现,除了要求单芯片低功耗之外,更要求整体架构设计的高效。

这也解释了像联想这样的服务器供应商,越来越强调液冷技术等“降耗神器”重要性的原因——如果不能提供能耗更低的数据中心解决方案,再高性能的单芯片计算方案在大规模集群面前也不具备性价比。