近日,李亚超教授团队博士后朱春宇以第一作者和共同通讯作者身份,在国际顶级期刊International Journal of Applied Earth Observation and Geoinformation(五年IF=7.5, 中科院一区前5% TOP)发表了题为 An Implicit Transformer-based Fusion Method for Hyperspectral and Multispectral Remote Sensing Image 的研究文章。

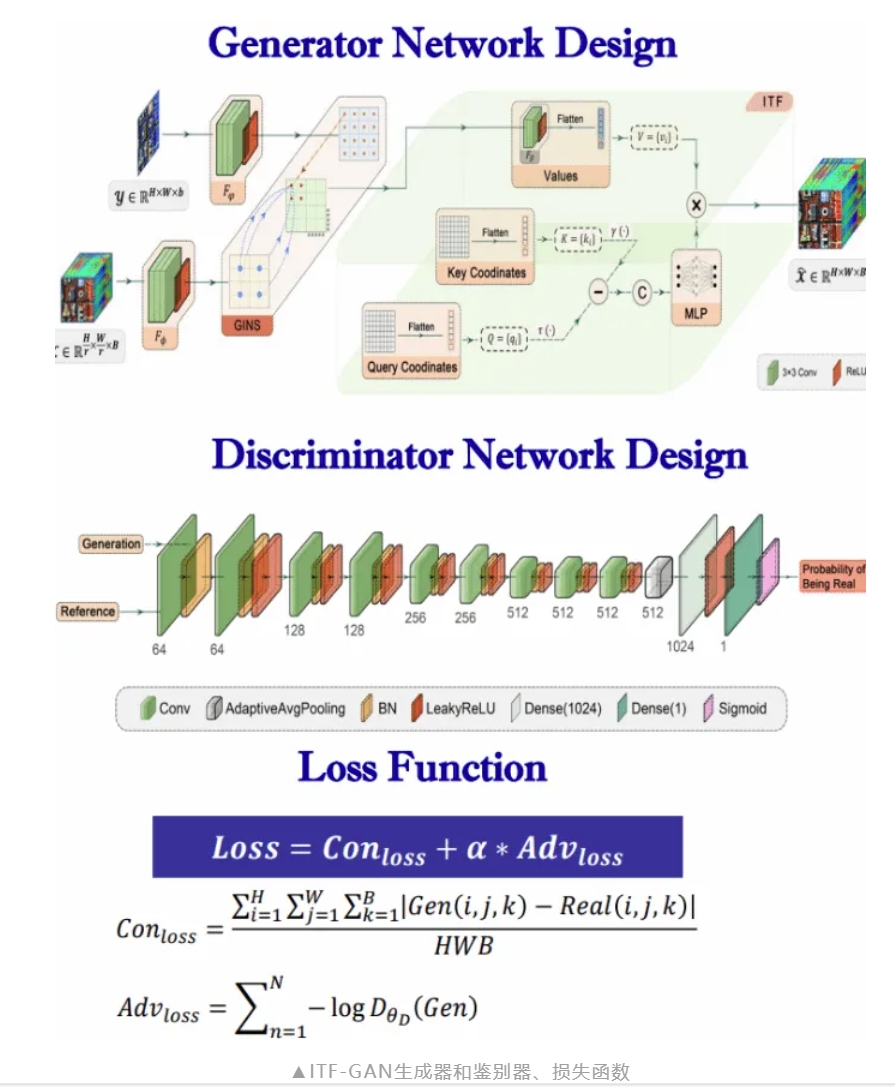

研究针对现阶段高光谱与多光谱遥感图像融合方法以离散方式实现像素级融合而导致融合精度不足的现状,提出一种新颖的隐式Transformer融合生成对抗网络(ITF-GAN),利用连续函数捕捉图像特征,设计了引导式隐式采样模块并引入生成对抗框架,实现离散融合转换为连续域感知,提高了融合精度。

在环境监测、土地分类和灾害检测等领域

高光谱遥感图像(HSI)

因具备丰富的光谱分辨率特性

具有广阔的应用空间

然而,由于传感器的物理限制

HSI的空间分辨率较低

相比之下

多光谱遥感图像(MSI)

具有较高的空间分辨率

可以更完整地描述土地覆盖格局和分布

但其光谱分辨率较低

在实际应用中

需要同时具备高空间分辨率和高光谱分辨率

为了满足应用需求

通常采用图像融合技术

将不同传感器获取的相同场景数据融合

重建高空间分辨率高光谱遥感图像

(HR-HSI)

然而

现有大多数深度融合技术和算法因其方法特性

在采样过程中无法有效保留图像细节和纹理特征

最终导致空间细节保真度降低

以及关键空间光谱特征丢失

此外

现有的深度学习方法

在融合过程中常通过离散域拟合方法

实现像素级融合

然而对于人类视觉而言

场景是以连续形式表达

因此在融合过程中

必须考虑使用连续函数来近似图像的真实状态

为解决以上问题

研究提出了一种新颖的

隐式Transformer融合生成对抗网络

(ITF-GAN)

这一方法采用点对点的方式隐函数

能够将隐式神经表示的连续性感知机制

与Transformer架构

强大的自注意力机制相结合

有效地处理空间和光谱维度信息

此外

研究提出的方法

在高光谱图像上采样过程中

引入引导隐式神经采样模块

能够增强空间域和光谱域特征的协调表达

提高融合图像的空间分辨率和光谱保真度

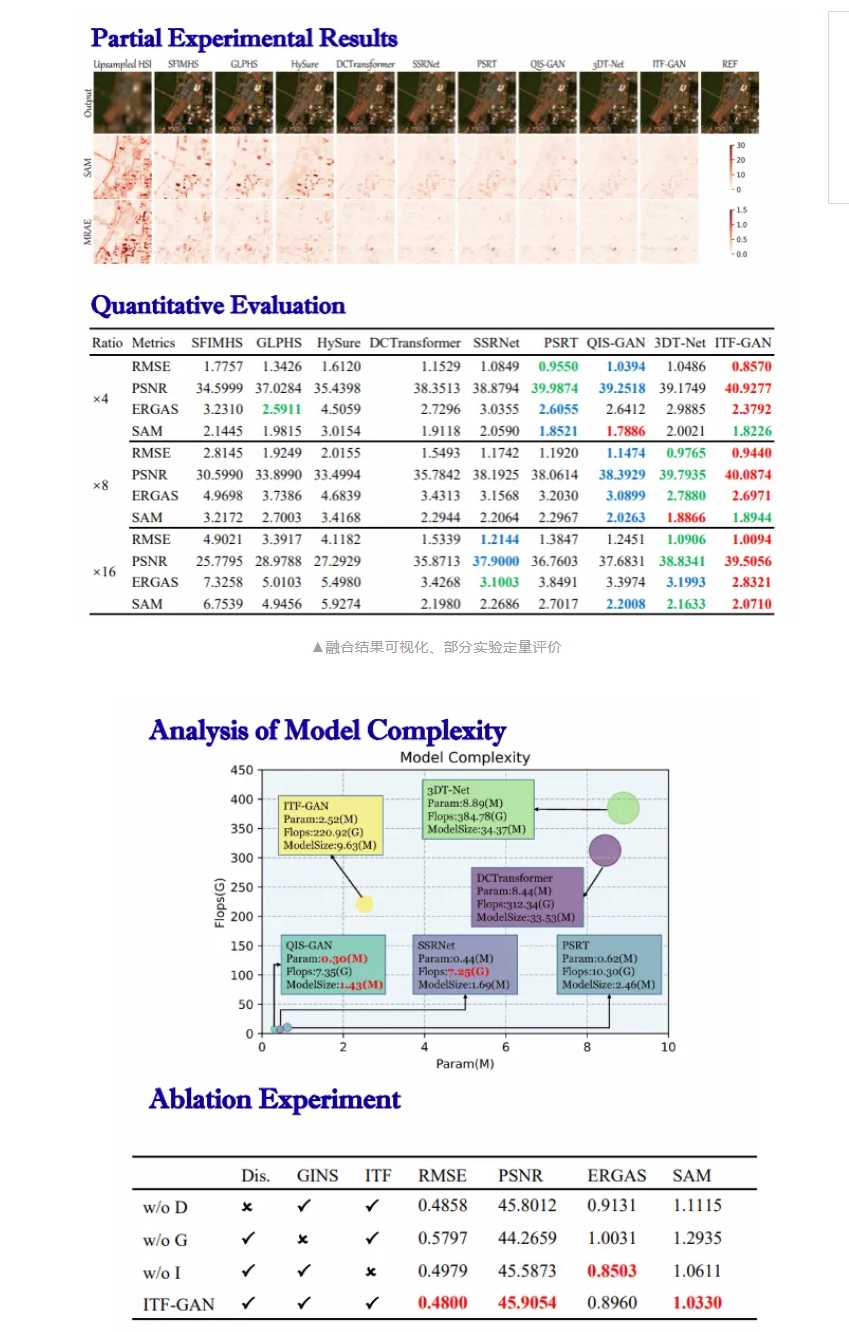

在4x、8x、16x空间分辨率差异下的

一系列融合实验结果表明

ITF-GAN无论是在客观评价指标

还是主观视觉评价上

都比当前流行的融合算法具有显著优势